Trendlicht: Unternehmensdaten effizient nutzen

Artikel: Bahn frei für Big Data

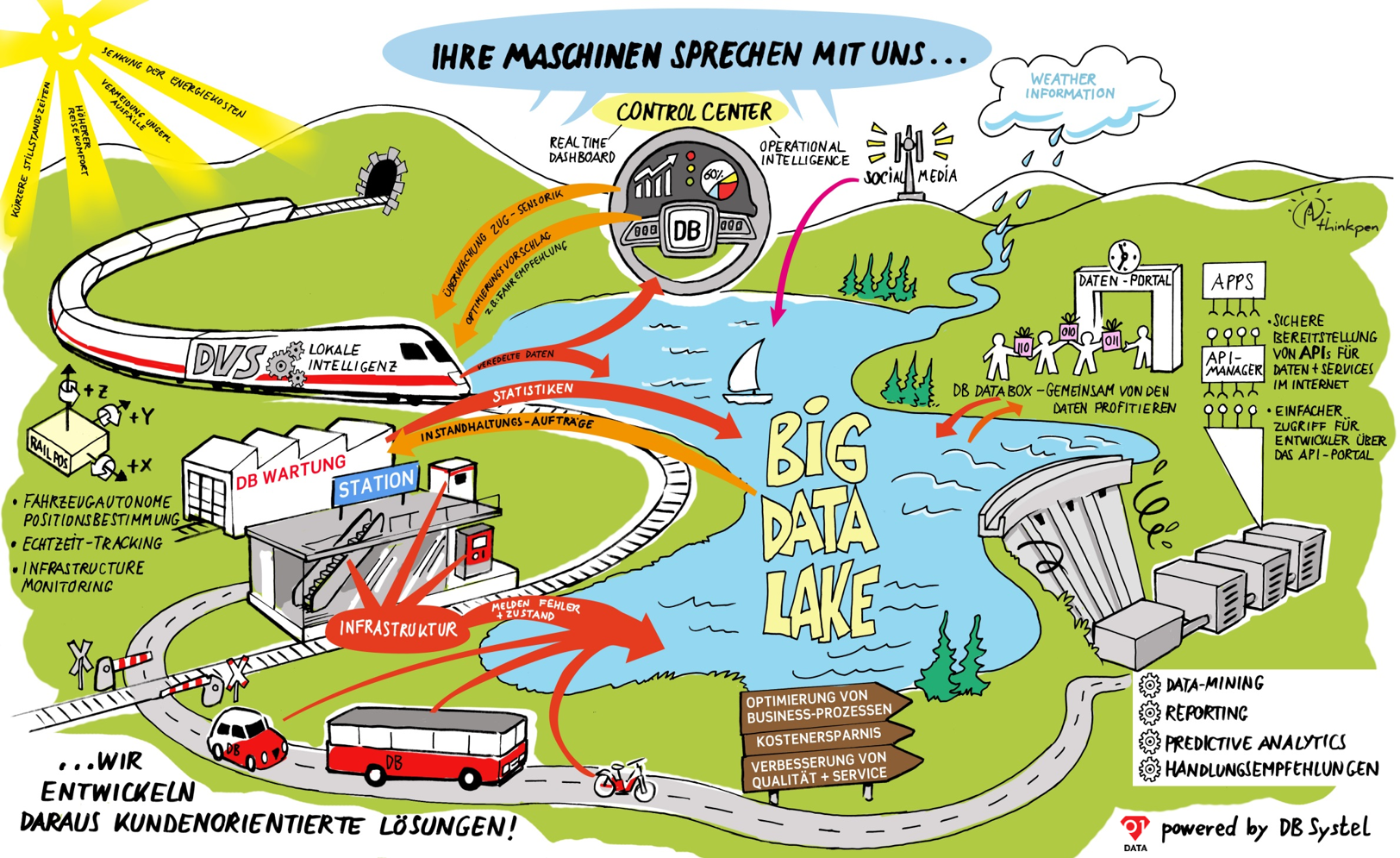

06/2018 – Big Data prägt mit vielen Anwendungsfällen auch die Deutsche Bahn – und ist längst nicht mehr nur für Datenspezialisten interessant. Aber was verbirgt sich eigentlich hinter dem Schlagwort? Was muss man tun, um große Datenmengen optimal zu nutzen?

Wir erschaffen Big Data, wenn wir morgens die erste App öffnen, das Digitalradio anschalten, und mancher sogar schon, wenn er seine Zähne mit der vernetzten Zahnbürste putzt. Ein Strom an Daten ergießt sich aus unserem digitalen Alltag in die riesigen Serverfarmen weltweit. Auch bei der Deutschen Bahn ist das Datenaufkommen inzwischen gewaltig. Schließlich entstehen bei jedem Ticketverkauf, jeder Bahnfahrt, in jedem Zug und überall in der DB-Infrastruktur ständig neue Daten, rund um die Uhr, an jedem Tag des Jahres.

Big Data bezeichnet Datenmengen, die so groß sind, dass sie mit herkömmlichen Methoden der Datenverarbeitung nicht mehr auswertbar sind. Diese Datenschwemme ist der Fingerabdruck unserer digitalisierten Welt. Jeder der rund acht Milliarden Menschen auf der Erde brauchte inzwischen 22 Gehirne, um alles zu speichern, was an Informationen zurzeit global verfügbar ist. Und Big Data wächst weiter: alle zwei Tage um die Datenmenge, die vom Entstehen der Schrift bis zum Jahr 2000 zusammenkam.

Der Grund für diese regelrechte Datenexplosion: Immer mehr Menschen betreiben mittels digitaler Technik Informationsaustausch. Und aus diesem beachtlichen Datenfluss wurde ein gigantischer Strom, als Unternehmen begannen, Dinge miteinander zu vernetzen. Heute kommunizieren Industrieroboter in Fertigungsstraßen, übermitteln Autos den Herstellern ihre Betriebsdaten, und ICE werden per Zugsensorik überwacht.

Perfektes Optimierungswerkzeug

Die vielen bei solchen Vorgängen entstehenden Daten werden gespeichert. Aber warum eigentlich? Und warum machen sich Unternehmen wie die Deutsche Bahn die Mühe, sie zu analysieren? Der Grund ist, dass man mit diesen Daten eine Menge herausfinden kann. Sie lassen sich lesen wie ein Buch. Sie sind ebenso eine Chronik vergangener Vorgänge wie ein Spiegel der Gegenwart. Bestimmte Analysetechniken extrahieren aus Big Data sogar Handlungsempfehlungen für die Zukunft.

Big Data birgt also erhebliche Möglichkeiten. Und die möchte sich die Deutsche Bahn nicht entgehen lassen. „Sie will mit ihrer konzerneigenen Datenstrategie zum führenden Big-Data-getriebenen Mobilitäts- und Logistikunternehmen werden“, sagt Joachim Bürkle, Leiter des DB Systel Corporate Start-ups Zero.One.Data. „Der Konzern stellt Daten in den Mittelpunkt der Entwicklung neuer Geschäftsmodelle. Und auch bei der Optimierung der Kernprozesse wird vieles mit der Analyse großer Datenmengen einhergehen.“

Daten werden oft als Rohöl des digitalen Zeitalters bezeichnet. Wie jedoch die Erfahrung zeigt, ist der Besitz von Rohstoffen kein Garant für das Wohlergehen eines Gemeinwesens. Ähnlich ist es mit digitalen Rohdaten. Viel hilft nicht immer viel. „Durch die Digitalisierung von Geschäftsprozessen wachsen die Datenmengen unserer Kunden sehr schnell an“, weiß Joachim Bürkle. Die von der Deutschen Bahn beschlossene Datenstrategie will helfen, Big-Data-Möglichkeiten einfacher und schneller zu erkennen, die jeweiligen Anwendungsfelder („Use Cases“) schneller umzusetzen und unzureichende Datenqualität zu verbessern.

Wie schürft man digitales Gold?

Wirklich groß wird Big Data erst, wenn der Datenerzeuger mithilfe der neuen Möglichkeiten einen Mehrwert erzielt: Wenn der Besitzer eines Fitnesstrackers seine Blutzuckerwerte unter Kontrolle bringt, der Autobesitzer sich einen teuren Werkstattbesuch erspart oder eine Stadt ihre Kriminalitätsrate absenken kann, gelingt die Transformation von Big Data in das, was IT-Experten „Smart Data“ nennen. Umgemünzt auf die Deutsche Bahn hieße dies zum Beispiel: Senkung von Energiekosten, weniger ungeplante Zugausfälle oder zuverlässiger funktionierende Fahrstühle und Rolltreppen.

Bei Zero.One.Data wird die dafür notwendige Datenveredlung durch professionelle Beratungs-leistungen, auf den Kunden zugeschnittene Softwareanwendungen und hoch effiziente Hardwarelösungen erreicht. Das gewährleistet eine adäquate Speicherung, Analyse und Darstellung der Daten des Geschäftspartners.

Doch wie entsteht Smart Data? Dafür braucht es mathematische Werkzeuge, die sogenannten Algorithmen. Mit deren Hilfe lassen sich in riesigen unstrukturierten Datenmengen bestimmte Muster erkennen, Charakteristika und Verläufe. Im Prinzip stellen Algorithmen exakte und zielgerichtete Handlungsanweisungen für Computer dar, der die Datenmengen durchforstet.

Auch bei der Deutschen Bahn stellen Daten an sich noch keinen Wert dar. Diesen bekommen sie erst, wenn sich Analytics-Teams darum kümmern, aus den Data Lakes der Deutschen Bahn relevante Daten zu einem bestimmten Sachverhalt zu extrahieren. Zuvor haben die Datenverantwortlichen der Fachabteilungen, die sogenannten Data Owner, dafür gesorgt, dass bei der Einspeisung der Daten bestimmte Qualitätsstandards eingehalten werden. Dies geschieht entsprechend der Leitlinien, die von der zentralen Data-Governance der Deutschen Bahn AG definiert werden.

Keine Angst vor großen Daten

„Natürlich haben die DB-Geschäftsfelder und ihre Mitarbeiter einen unterschiedlich intensiven Bezug zur Digitalisierung“, weiß Joachim Bürkle. „Entsprechend individuell ist auch das Verhältnis zur Nutzung von Daten und die Intensität des Einsatzes von Data-Intelligence-Methoden.“ Aber fest steht, dass die Analyse von Daten für jede Abteilung der Deutschen Bahn Vorteile birgt. Nicht nur, weil sich erst dadurch herausstellt, ob das Geschäftsfeld auch die richtigen Daten sammelt, sondern weil Data Intelligence ganz konkrete Handlungsempfehlungen geben kann. Angst vor Zahlenkolonnen muss niemand haben. Die Daten lassen sich leicht verständlich in Form von Dashboards visualisieren.

Das Leistungsspektrum von Big-Data-Analytics ist vielfältig. Im Bereich der Asset Intelligence kann die Analyse zum Beispiel Instandhaltungsprozesse optimieren. Financial Intelligence ermöglicht unter anderem Echtzeiteinblicke in unternehmensweite Einkaufs-, Controlling- und Finanzdaten. Und auf dem Gebiet der Customer Intelligence kann Social-Media-Analyse sowie Textmining zu einer verbesserten Kommunikation mit dem Kunden führen – natürlich unter Wahrung der Datenschutzverordnung und nur, wenn sich der Fahrgast damit einverstanden erklärt.

Und auch wenn es Big Data heißt: Das einzelne Projekt muss nicht gleich am großen Rad drehen. „Bei Zero.One.Data bevorzugen wir ein agiles Vorgehen, um relativ leicht zu überblickende Analysestrukturen und -algorithmen zu entwickeln“, sagt Joachim Bürkle. Ziel ist die Entwicklung von Minimum Viable Products (MVP), also günstigen, übersichtlichen und schnell einsetzbaren „Testballons“ in Sachen Big Data. Sie sind der erste Schritt auf dem Weg zu größeren Projekten.

Ob MVP oder Großprojekt: Das vertrauensvolle Zusammenspiel der DB-Geschäftsfelder und der Analytics-Teams stellt die Basis für ein erfolgreiches Big-Data-Projekt dar. „Es braucht eine enge Zusammenarbeit mit dem Kunden“, weiß Joachim Bürkle. „,Think big, start small‘ ist der perfekte Einstieg, das Potenzial von Big Data in der eigenen Abteilung zu entdecken.“

Big Data bei der Deutschen Bahn: die Hotspots

Sie würden gern mehr über die verschiedenen Big-Data-Aktivitäten im Konzern erfahren? Dann ist die Analytics Community DB auf DB Planet (nur für DB-Mitarbeiter zugänglich) genau das Richtige für Sie. Hier findet ein regelmäßiger Austausch der Data Scientists, Data Analysts und Data Engineers im DB Konzern statt.

Big DataEntstehen Daten in einer Größenordnung, Unterschiedlichkeit und Geschwindigkeit, die nicht mehr von herkömmlichen Datenbanken gespeichert und von gebräuchlichen Tools für das Datenmanagement zu bewältigen sind, spricht man von Big Data. Um sie zu geschäftlichen oder Forschungszwecken zu nutzen, werden sie unter einer bestimmten Fragestellung mittels mathematischer Formeln (Algorithmen) analysiert.

Business Intelligence /Business AnalyticsWenn ein Unternehmen wissen möchte, wie es sich in einer bestimmten wirtschaftlichen Situation verhalten soll, kann Big Data ihm dabei helfen. Dazu werden alle Unternehmensdaten gesammelt, unter einer Fragestellung ausgewertet und visualisiert, ob als Balkendiagramm, Tortenform oder in einer anderen Art. Die Kennzahlen am Monatsende oder Quartalsende werden mit denen aus der Vergangenheit verglichen (was ist wann passiert?) und helfen bei der Entscheidungsfindung im Jetzt-Bereich.

Data MiningStatistik, Mathematik und Algorithmen sind das Handwerkzeug des sogenannten Data Mining, also des gezielten Suchens und Auswertens von nützlichen Informationen mittels statistischer Methoden aus großen Datenmengen. Es geht darum verborgene Muster und Zusammenhänge zu erkennen. Oft verwendete Verfahren sind Clustering (Bildung von Gruppen sich ähnelnder Daten), Regressionsanalyse (was hängt von welchen anderen Faktoren ab?) und Assoziationsanalyse (wenn das eine passiert, passiert auch das andere).

Data LakeTagtäglich erzeugt jeder Mensch um die 650 Megabyte an Daten. Hinzu kommen die Daten aus der Industrie 4.0. Damit Unternehmen der Datenflut Herr werden, liegt die Schaffung eines Data Lake nahe. Das ist ein zentraler Ort, an dem jede Abteilung ihre Daten ablegen kann, wo aber auch externe Daten landen. Der Data Lake ist das elektronische Gedächtnis eines Unternehmens. Damit aus dem See kein Sumpf wird, ist es aber notwendig zu wissen, welche Daten wirklich einen Wert darstellen und mit welchen Techniken und zu welchem Zweck sie zukünftig einmal analysiert werden sollen.

Smart DataWährend Big Data und der Data Lake aus strukturierten Daten (etwa Tabellen) und unstrukturierten Daten (etwa Word-Dokumenten) diversen Ursprungs bestehen, handelt es sich bei Smart-Data-Beständen um zu einem bestimmten Zweck mit bestimmten Algorithmen und anderen Werkzeugen untersuchte Daten. Mit ihnen können Geschäftsmodelle entwickelt, Betriebsabläufe und Entscheidungsprozesse optimiert werden.

- Descriptive AnalyticsDiese Grundform der Datenanalyse nutzt Big Data, um herauszufinden, was genau in der Vergangenheit passiert ist. Man nimmt an, dass es sich bei mehr als 80 Prozent der Business Analytics um Descriptive Analytics handelt. In den meisten Fällen wird bei Descriptive Analytics gezählt, gefiltert und Arithmetik angewendet. Zusätzlich kann noch analysiert werden, warum etwas in der Vergangenheit passiert ist. Diese Erweiterung wird gelegentlich Diagnostic Analytics genannt.

- Predictive AnalyticsDiese Form von Analytics ist quasi die zeitliche Ausweitung der Descriptive Analytics in die Zukunft. Auf Basis historischer Daten errichtet man ein statistisches Model, um zu ermitteln, was in Zukunft passieren könnte. Predictive Analytics entdeckt Trends, Cluster und Sonderfälle. Dazu nutzt man Data Lakes, Algorithmen und künstliche Intelligenz. Im Grunde genommen verwendet man existierende Daten aus der Vergangenheit, um nicht existierende Daten der Zukunft zu erstellen. Ziel ist, auf Grundlage von Datenmodellen Entscheidungsmöglichkeiten zu entwickeln. Wenn zum Beispiel eine KI in der Lage ist, die Stimmung eines Textes zu analysieren, stellt dies eine Form von Predictive Analytics dar. Denn aus dieser sogenannten Sentiment Analysis ergeben sich variable Handlungsmöglichkeiten.

- Prescriptive AnalyticsAufgrund des technologischen Fortschritts in der Big Data Analyse ist es zunehmend möglich nicht nur Vergangenheit und Ist-Zustand mittels Daten zu konstruieren, sondern auch vorherzusagen, was unter bestimmten Umständen in der Zukunft passieren wird. Prescriptive Analytics geht also noch einen Schritt weiter als Predictive Analytics. Es gibt Unternehmen multiple Handlungsanweisungen in Form von datengestützten Zukunftsszenarien an die Hand: Was könnte man tun, damit das eine oder das andere in Zukunft passiert? Zwingend notwendig ist dazu aber ein möglichst beständiger Strom von Feedback Data. Das macht Prescriptive Analytics zu einer schwierigen Sache.